Durante más de una década, el smartphone fue el centro de nuestra vida digital. Trabajo, comunicación, entretenimiento, pagos y hasta salud pasaron por una pantalla que llevamos siempre en el bolsillo. Pero esa hegemonía empieza a resquebrajarse. En el horizonte tecnológico aparece un nuevo protagonista: las gafas inteligentes impulsadas por inteligencia artificial.

Lejos de ser un experimento futurista, distintos actores de la industria tecnológica coinciden en que los smart glasses serán el próximo dispositivo esencial, del mismo modo en que hoy lo es el celular. La diferencia es profunda: la interacción ya no pasa por una pantalla que miramos, sino por información que se integra directamente en nuestro campo visual y auditivo, de forma continua, contextual y personalizada.

Según proyecciones citadas por medios especializados como MIT Technology Review y Popular Science, a partir de 2026 estas gafas no solo mostrarán datos en tiempo real, sino que adaptarán la experiencia digital a los hábitos, rutinas y necesidades de cada usuario mediante asistentes de voz, sensores avanzados y realidad aumentada.

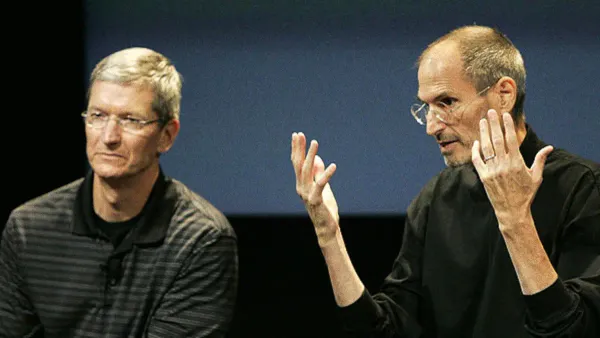

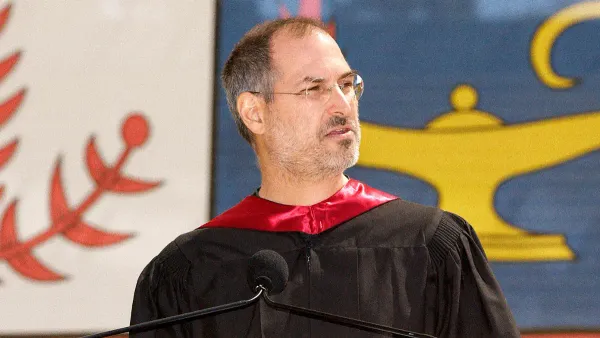

La visión de Zuckerberg y el paralelismo con los smartphones

Uno de los principales impulsores de este cambio es Mark Zuckerberg, CEO de Meta y dueño de WhatsApp. Su postura es clara y cada vez más contundente.

Para Zuckerberg, es “difícil imaginar un mundo, dentro de algunos años, donde la mayoría de las gafas que la gente usa no sean gafas con IA”.

El empresario compara esta transición con la que vivimos con los smartphones: no será un cambio abrupto, sino una evolución progresiva de un objeto que ya usamos todos los días. Las gafas, a diferencia del celular, no interrumpen la interacción humana: la acompañan.

En otra de sus definiciones más directas, sostuvo que “dentro de 10 años muchas personas ya no llevarán sus teléfonos consigo, usarán sus gafas para todo”.

Su argumento es que los celulares se volvieron dispositivos pequeños, distractivos y socialmente invasivos, mientras que las gafas permiten integrar tecnología sin desconectarnos del entorno físico.

Por qué la IA es el verdadero motor del cambio

El avance de las smart glasses no se explica solo por el hardware, sino por la madurez de la inteligencia artificial. Los modelos actuales ya son capaces de procesar múltiples variables en tiempo real:

- Distancia de lectura

- Movimientos oculares y de cabeza

- Fatiga visual

- Condiciones de iluminación ambiental

Estos datos alimentan gemelos digitales que ajustan automáticamente la configuración óptica y la experiencia visual según cada persona. En la práctica, esto permite gafas que aprenden del usuario, optimizando foco, contraste, brillo y asistencia contextual sin intervención manual.

Un solo dispositivo para ver, oír y entender el entorno

Otro salto clave es la convergencia entre salud visual y auditiva. Algunos modelos recientes incorporan:

- Micrófonos direccionales

- Altavoces de oído abierto

- Asistencia auditiva configurable desde apps

Esto convierte a las gafas en un dispositivo multisensorial, capaz de amplificar no solo lo que vemos, sino también lo que escuchamos, con filtros inteligentes que priorizan información relevante.

Zuckerberg lo define como el “formato ideal para la superinteligencia personal”. Un dispositivo que ve, oye y habla con el usuario durante todo el día, generando información útil en tiempo real.

Las dudas: privacidad, salud y aceptación social

No todo es entusiasmo. El debate alrededor de las smart glasses también está cargado de interrogantes.

Según datos de la Organización Mundial de la Salud, el 85% de las personas mayores de 40 años sufre presbicia, una condición visual natural y progresiva que dificulta el enfoque en objetos cercanos. A eso se suma que pasamos, en promedio, seis horas diarias frente a pantallas, cifra que puede llegar a diez horas en entornos de oficina.

Pero el mayor foco de debate es la privacidad. Cámaras, sensores y asistentes virtuales integrados en gafas de uso cotidiano generan preocupación sobre:

- Vigilancia involuntaria

- Uso de datos personales

- Grabaciones en espacios públicos

Organismos europeos ya reclaman marcos regulatorios claros, sistemas de cifrado avanzado y total transparencia sobre qué datos se recopilan, cómo se procesan y con qué fines.

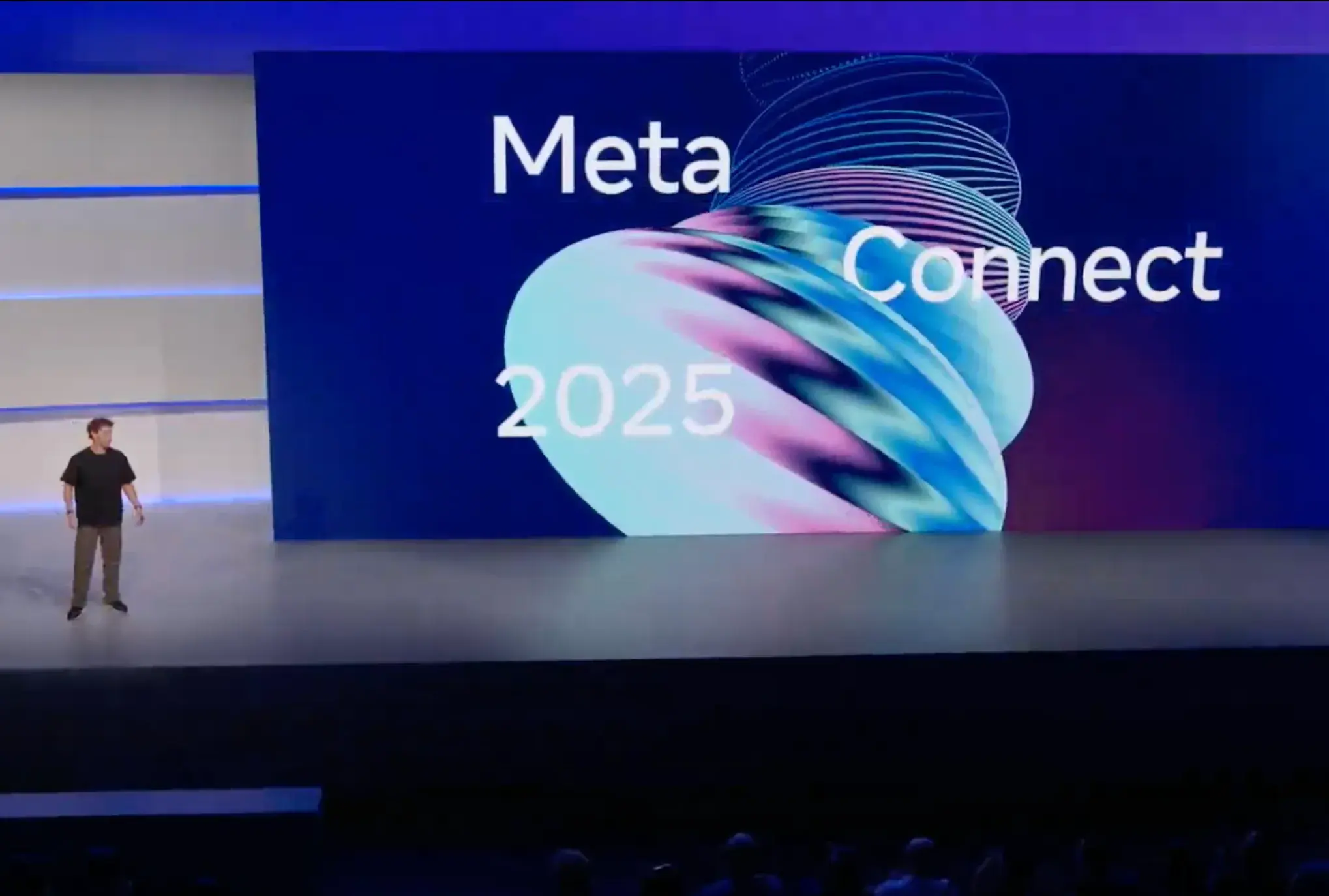

Meta Ray-Ban Display: el primer paso concreto

En el evento Meta Connect 2025, celebrado en septiembre, Meta presentó su modelo más avanzado hasta ahora: las Meta Ray-Ban Display.

Estas gafas integran:

- Pantalla monocular de alta resolución, invisible para terceros

- Realidad aumentada para notificaciones, traducción en tiempo real, subtítulos y navegación

- Control por voz, gestos y una Neural Band que interpreta impulsos musculares

Todo esto sin sacar el celular del bolsillo.

Aunque todavía dependen de un dispositivo base para algunas funciones, el camino hacia la independencia total del smartphone ya está trazado.

¿Qué podemos aprender?

- La próxima gran disrupción no será una app, sino un cambio de interfaz.

- La IA contextual será más valiosa que la potencia bruta del hardware.

- Los dispositivos que reducen fricción y se integran de forma natural al cuerpo humano tienen mayor adopción.

- La privacidad y la regulación serán tan importantes como la innovación tecnológica.

- Las oportunidades para emprendedores no están solo en fabricar hardware, sino en software, servicios, experiencias y nuevos modelos de negocio alrededor de este ecosistema.

Reflexión final

El celular no desaparecerá de un día para el otro. Pero, como ocurrió con muchas tecnologías dominantes, su centralidad está siendo cuestionada. Las smart glasses representan algo más profundo que un nuevo gadget: proponen una forma distinta de convivir con la tecnología, menos invasiva, más integrada y cada vez más inteligente.

La pregunta ya no es si este cambio va a ocurrir, sino quiénes estarán preparados para construir sobre él.

Escrito por